Si vous rencontrez des difficulités avec votre chien et que vous travaillez avec un·e comportementaliste compétent·e, il est fort probable qu’iel vous ait à un moment donné parlé de faire une collecte de données.

En général, l’objectif est de parvenir à identifier les facteurs qui influencent la problématique pour pouvoir mieux cibler le traitement initial, suivre les progrès, et adapter les mesures mises en place en fonction de ce qui fonctionne mieux ou moins bien.

Indirectement, cela permet aussi de prendre du recul par rapport à nos impressions (”Mirza aboie toujours, pendant toute la balade !”) en quantifiant précisément ce qui se passe. De la même manière, lorsque le travail s’étale sur plusieurs mois ou plusieurs années, cela permet de mieux voir les progrès, en particulier lorsqu’ils sont en dents de scie : en constatant que, malgré tout, de mois en mois, il y a des progrès constants, même s’ils sont subtils, cela permet de rester motivé·e·s pour continuer le travail.

Mais comment faire une collecte de données ?

Comme toujours, la réponse est : ça dépend.

Ca dépend de ce qu’on veut récolter comme données, mais cela dépend aussi des préférences de chacun. En photographie, on dit souvent que le meilleur appareil photo, c’est celui qu’on a avec soi : ça ne sert à rien d’avoir un mangnifique reflex haut de gamme avec des optiques qui coutent le prix d’une voiture, si c’est pour le laisser tout le temps à la maison parce qu’il est trop lourd, et au final faire quand même toutes ses photos avec son smartphone. C’est la même chose pour les collectes de données : cela n’a pas de sens de construire un magnifique tableau Excel avec plein de formules et de réglages avancés… si au final, le temps de rentrer de la balade, on a quand même oublié tout ce qui s’est passé avant d’avoir pu le noter dans ce magnifique tableur. A l’inverse, cela n’a pas de sens non plus de tout noter dans un petit carnet en papier, si quand on rentre à la maison on ne sait plus se relire, ou qu’on ne sait pas analyser ces données parce que le format n’est pas propice aux calculs…

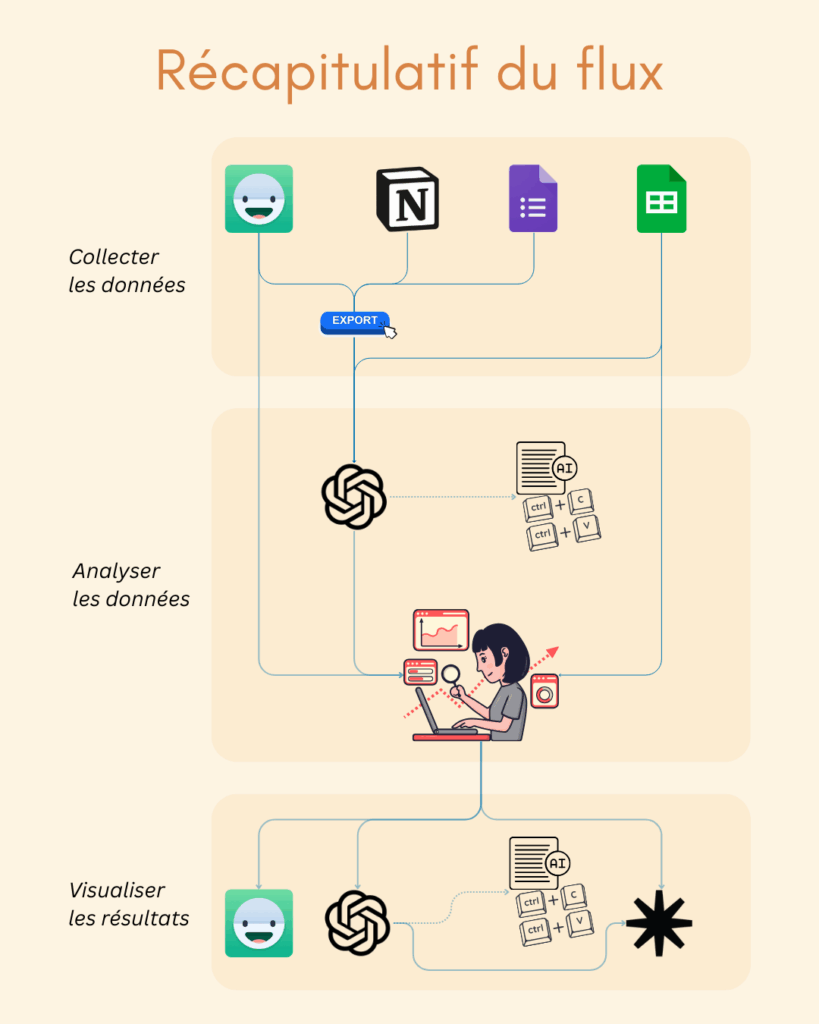

Il n’y a donc pas de solution miracle : cela dépendra de ce qui est les plus adapté à ce que vous voulez collecter. Par contre, j’ai une bonne nouvelle : c’est au final un processus très modulable, et il y a moyen de construire chacun sa petite solution personnalisée à partir de différentes briques existantes. On va en voir quelques unes pour chaque étape du processus, à savoir :

- La collecte en elle-même : comment on va encoder nos données, au fur et à mesure des événements

- L’analyse des données

- La visualisation des résultats

Et seconde bonne nouvelle : comme vous allez le voir, au final, ce n’est pas si compliqué que ça !

La Collecte des données

Comme je l’ai évoqué plus haut, la méthode que l’on va choisir doit impérativement répondre à deux exigences, sous peine de ne servir à rien du tout :

- Il faut que l’encodage soit pratique par rapport à ce qu’on veut collecter

- Il faut que les données encodées soient facilement exploitables.

Noter dans un petit carnet papier en balade, c’est pratique, mais les résultats sont difficiles à exploiter ; inversement, des données encodées directement en Excel sont facilement exploitables pour l’analyse, mais ce n’est pas forcément pratique à encoder, surtout si on veut noter des éléments qui se passent en balade, quand on est loin de son ordinateur.

Pour pouvoir déterminer la meilleure méthode pour notre cas, nous devons tout d’abord nous poser deux questions essentielles :

- Quel est le critère dont je veux observer la variation ? Autrement dit, quelle est ma “variable dépendante” ? Par exemple : l’intensité de la réaction de mon chien quand il est confronté à un déclencheur, ou quel est l’état de sa digestion ?

- Quels sont les facteurs dont je veux observer l’influence sur ce critère ? Bien sûr, si on savait d’avance exactement ce qui influence l’état de notre chien, on n’aurait pas besoin de collecte de données. Mais, par contre, on ne peut pas noter ce qu’on n’a pas pensé de noter. Si mon chien est plus sensible les jours de pluie, mais qu’il ne m’est jamais venu à l’idée que la météo pouvait jouer un rôle, je risque de ne jamais m’en rendre compte… C’est pourquoi les collectes de données sont toujours destinées à évoluer : imaginons que j’aie pensé à noter la distance à laquelle mon chien réagit… Il est possible qu’un jour, je me dise : “ouille, il a pété un plomb, pourtant on n’est qu’à 50 mètres, normalement il gère à cette distance… Mais bon aujourd’hui c’est pas pareil, il y a un tel orage qu’on ne voit rien à 30 mètres…”. Ce jour-là, je vais peut-être tout à coup réaliser que la météo a un impact, alors que si je n’avais pas pensé à noter les distances, je ne l’aurais peut-être jamais remarqué. A force d’observer certains facteurs, on finit par prendre compte d’autres facteurs auxquels on n’aurait pas pensé avant… Et à ce moment-là, on comence à les noter dans notre collecte.

Le plus important pour commencer est donc de déterminer ce qu’on veut observer, parce que cela va directement conditionner la granularité de notre collecte : autrement dit, ce qui constitue une entrée, un encodage. Imaginons que je veuille observer la qualité de sommeil de mon chien : une seule entrée par jour est probablement suffisante. Je noterai le nombre de balade de la journée, leur temps total, si il a été stressé ou non, à quelle heure il a eu son dernier pipi et son dernier repas, et finalement combien d’heures il aura dormi jusqu’au matin suivant. Si par contre je veux noter comment mon chien gère ses potentiels déclencheurs (ce à quoi il est sensible) pour repérer les paramètres qui font qu’une fois ça passe, une fois ça ne passe pas, alors je devrai probablement faire une entrée à chaque déclencheur rencontré…

- Si je fais une entrée par jour où je relate globalement les événements de la journée, je peux éventuellement me poser 10 minutes tous les jours devant mon ordinateur et encoder cela directement dans un fichier Excel ou un Google Sheets.

- Si par contre je dois pouvoir encoder sur le vif quand je suis hors de chez moi, comme pour une collecte précise en balade, il me faudra un outil pratique à utiliser en balade.

‣ Excel ou Google Sheets

Avec une collecte en Excel ou en Google Sheets, on est sur une voie royale pour l’analyse postérieure, ça c’est évident. Par contre, ces deux outils ne sont pas très pratiques pour encoder les données à partir d’un smartphone ou d’une tablette : à réserver à des collectes pour lesquelles on a le loisir d’encoder tranquillement sur l’ordinateur, maximum une fois par jour…

‣ Daylio

Vous connaissez probablement Daylio, j’ai déjà écrit un long article à son sujet. Je ne vais pas plus revenir dessus ici, sauf pour mentionner son (seul) gros défaut : il ne permet de faire qu’une seule collecte de données à la fois, et si je modifie les paramètres (les humeurs ou les activités), cela impacte également toutes les entrées passées. Il reste donc très pratique pour une première collecte, mais sur le long terme ou pour les cas plus complexes, ses limitations sont problématiques.

‣ Le carnet papier

Je le note ici juste pour être complet, mais je le déconseille vraiment, parce que ça impose de s’astreindre à tout retranscrire de manière informatique par la suite pour pouvoir procéder à des analyses plus poussées.

‣ Les formulaires Google Forms

Vous avez déjà certainement rencontré Google Forms si vous avez répondu à des questionnaires pour des associations ou pour des étudiant·e·s qui faisaient leur mémoire. Vous n’avez par contre peut-être pas encore vu ce qui se cache derrière…

En réalité, chaque formulaire complété correspond à une ligne dans un tableau de type Google Sheets, où chaque question correspond à une colonne.

Or ces formulaires ont l’avantage de fonctionner assez bien sur smartphone : il est donc possible de créer un formulaire pour notre collecte de données, en remplissant le formulaire à chaque encodage, et récupérer toutes les données dans un Google Sheets derrière. Pratique !

Ce qui l’est un peu moins est le fait que Google Sheets a quelques limitations techniques qui peuvent être rébarbatives, notamment le fait qu’il est fortement conseillé d’encoder son adresse mail à chaque nouvel entrée, ou le fait qu’il est difficile de centraliser plusieurs collectes de données au même endroit (absence d’inferface intégrée)…

Mais vous allez voir, on dispose d’une variante un peu plus souple…

‣ Les Formulaires Notion

Si vous ne connaissez pas encore Notion, il s’agit d’une sorte de bloc-notes assez puissant qui permet de prendre très vite des notes, et de les structurer, les mettre en forme, ajouter des images, des liens… bref, se faire une sorte de petit Wikipédia à soi, si on veut. Si vous connaissez Microsoft OneNote, c’est le même principe. On peut tout y mettre en vrac, et aller retravailler cela par la suite pour ne rien perdre. Bref, ici, comme avec Daylio, on va un peu contourner l’usage initial de Notion pour en faire autre chose…

Notion a intégré il y a un peu plus d’un an un équivalent de Google Forms, mais en plus souple. On peut donc très facilement créer un formulaire pour nos collectes, qui enverra toutes les entrées dans un tableur. Il y a plusieurs gros avantages par rapport à Google Forms : tout d’abord, il est possible de créer facilement plusieurs collectes et de les rassembler au même endroit. Ici par exemple, j’ai créé deux collectes que je gère en même temps : je clique sur un bouton ou sur l’autre selon ce que je dois encoder à un instant donné.

Et ensuite, l’encodage en lui-même est moins contraignant techniquement que Google Forms, et donc plus rapide.

Créer un formulaire dans Notion

Encoder une entrée dans le formulaire Notion

Accéder aux réponses et les exporter

Une fois que vous avez créé le formulaire, si vous voulez pouvoir encoder sur votre smartphone sans passer par l’appli Notion, vous pouvez faire “Partager le formulaire”, et mettre “Tout internaute disposant du lien”. Ensuite vous pouvez faire “Copier le lien vers le formulaire”. Personnellement, je conseillerais de créer une page Notion et d’y coller le lien ou de créer un bouton avec le lien, comme ça il vous suffit d’ouvrir cette page ou la garder ouverte dans votre navigateur pour pouvoir commencer directement un encodage à tout moment en cliquant sur le lien ou le bouton. Il est aussi tout à fait possible de simplement coller le lien vers le fomulaire là où ça vous convient, ou l’enregistrer dans vos favoris.

Si vous êtes professionnel·le, et encore mieux si vous avez déjà un compte Notion payant, vous pouvez facilement préparer vous-même les formulaires, et ensuite les partager à vos client·e·s en leur donnant le lien, ce qui leur facilite le travail. Voire même préparer une page dans laquelle vous intégrez les différents liens et/ou boutons, pour qu’ils aient tout au même endroit via un seul lien, en cas de collectes multiples. Contrairement aux comptes payants, les comptes gratuits sont limités dans la taille des photos et vidéos qu’ils peuvent ajouter : si vous disposez d’un compte payant, créer vous-même les formulaires est un bon moyen de contourner cette limite, pour que vos clients puissent ajouter des photos et des vidéos dans leur encodage…

A noter toutefois, un défaut embêtant de Notion : vu que c’est un service uniquement en ligne, il a besoin de réseau pour fonctionner : impossible donc d’encoder une entrée via le formulaire si on n’a pas de réseau…

L’analyse des données

Vous pouvez bien sûr analyser les données manuellement en regardant vous-même le tableau, mais dans ce cas je n’ai rien à vous expliquer de particulier ici…

Je vais par contre aborder un outil que vous connaissez certainement mais auquel vous n’aviez peut-être pas pensé pour ceci: ChatGPT.

Bien sûr, son utilisation a un coût écologique, et je pense bien sûr qu’il faut le prendre en compte. Cependant, je pense aussi que le bien-être de nos chiens est un enjeu qui est loin d’être futile, surtout si l’utilisation de cet outil apporte une plus-value significative par rapport aux autres possibilités disponibles. En l’occurrence, analyser des données de manière traditionnelle demande des compétences très spécifiques et difficiles à acquérir en dehors des parcours universitaires qui comprennent des cours de statistiques. ChatGPT rend donc accessible ces compétences à un public bien plus large, et cela peut avoir un impact décisif sur nos capacités à aider nos chiens. Ca reste une évaluation éthique personnelle à faire, mais je pense qu’on y gagne à être conscients de ce que cela peut nous permettre.

Encore une mise en garde importante : comme on le verra, ChatGPT est capable de faire des choses impressionnantes. Il peut donc être tentant d’aller trop loin et de lui demander de faire notre travail à notre place. La pente est glissante. Si vous lui demandez de faire votre bilan à votre place, il le fera. Si vous lui demander de préparer un plan de travail à votre place, il le fera. Et pour ce que j’ai pu tester, ses conseils ne sont pas complètement absurdes. Mais est-ce que ce sera suffisamment adapté au cas précis ? Est-ce qu’il n’y aura pas des problèmes avec certaines techniques qu’il propose, qui seraient contre-productives dans le cas spécifique dont on s’occupe ? De même, il ne peut pas deviner ce que vous ne lui avez pas dit : le réel est toujours infiniment complexe, et il y aura toujours des aspects de cette complexité que vous n’aurez pas mentionné, voire même pas remarqué du tout. Il faut donc toujours rester extrêmement prudents, et toujours évaluer de manière critique les propositions qu’il vous fera. De la même manière que lorsqu’on lit un livre de comportement canin, on n’applique pas les méthodes proposées sans réfléchir, en somme…

Fondamentalement, cela ouvre une grande question, tant pour les gardien·ne·s que les comportementalistes : ChatGPT est-il aussi compétent qu’un·e comportementaliste ? Si c’est le cas, pourquoi encore aller consulter un·e comportementaliste ?

Il doit certainement déjà y avoir des comportementalistes qui utilisent ChatGPT pour lui faire faire leurs bilans et leurs plans de travail à leur place. Il y a déjà clairement des gardien·ne·s qui demandent des conseils comportementaux à ChatGPT. C’est très problématique : pas parce qu’il faudrait se méfier de la technologie, ou parce que ce serait une compétence déloyale, mais au contraire, parce que cela indique que ces personnes n’ont probablement pas les connaissances et les compétences nécessaires en comportement canin pour évaluer de manière critique ce que ChatGPT leur propose. En tant que gardien·ne·s, c’est normal, mais cela signifie qu’on risque de suivre de mauvais conseils sans s’en rendre compte ; en tant que comportementaliste, c’est problématique, parce que si on n’est pas plus compétent·e que ChatGPT pour notre propre métier, si on n’a rien à apporter de plus qu’un logiciel gratuit, autant arrêter tout de suite, parce qu’on vole nos client·e·s. Pour moi, c’est un outil extrêmement intéressant, mais pour autant qu’il s’agisse d’un outil qui nous permette de mieux travailler, d’aller plus loin dans nos analyses, pas de travailler à notre place.

Bref, si vous n’avez pas les compétences spécifiques dans un certain domaine pour repérer si ce qu’il vous dit est correct ou non (ou être capable de lui poser les bonnes questions pour vérifier), il vaut mieux éviter de l’utiliser pour ce domaine-là.

‣ La préparation des données

En l’occurrence, ChatGPT est capable d’effectuer des analyses statistiques extrêmement poussées, en particulier si on prend la peine de le guider. Il faut le voir comme un ami / expert / collègue très compétent dans son domaine (dans un tas de domaines, en fait), avec qui on peut avoir une conversation qui permet de creuser un sujet. Dans ce cas-ci, il faut le voir comme un ami statisticien et pédagogue, à qui on va pouvoir poser des questions sur nos données, et même lui demander de nous expliquer comment il a procédé.

Mais pour que ce soit pertinent, il faut garder en tête que, comme lorsqu’on parle à un comportementaliste ou à un collègue spécialisé, il ne connait pas notre cas comme nous : il ne sait que ce qu’on lui en dit.

Au mieux on lui explique le contexte de notre fichier de données, au mieux il pourra nous aider. Sans rentrer dans un cours complet de Statistiques (qui n’est pas ma spécialité, et que je serais donc incapable de donner), il est important de noter que les méthodes d’analyse statistique que ChatGPT va appliquer (qui sont celles qu’utilisent les scientifiques qui réalisent les études que nous lisons) seront différentes selon le type de données. Si notre fichier contient des nombres ou des pourcentages, ChatGPT saura de quoi il s’agit et comment les traiter. Par contre, et là ça peut changer beaucoup de choses dans notre analyse, s’il s’agit de texte, il ne peut pas deviner tout seul si les valeurs ont un ordre (techniquement, on parle de données catégorielles ordinales). Par exemple, si dans mes données, j’ai une colonne avec le niveau de réaction (”ignore”, “observe calmement”, “tendu mais parvient à gérer”, “pète un cable”), il s’agit d’une échelle hiérarchisée : c’est intéressant pour l’analyse de savoir que “tendu mais parvient à gérer” est une réaction moins pire que “pète un cable” mais moins idéale que “observe calmement”. Si par contre j’ai une colonne avec le type de déclencheur (”chien”, “vélo”, “joggeur”, “enfant”), il n’y a a priori pas de hiérarchie entre les différentes valeurs, elles sont juste différentes, comme des pommes et des poires. Or il n’y a que nous qui pouvons indiquer avec certitude à ChatGPT si il doit considérer des valeurs en texte comme hiérarchisées, et dans quel ordre, comme on le ferait avec un logiciel d’analyse statistique comme SPSS ou Jamovi. Et cela va changer les méthodes d’analyse statistiques qu’il va pouvoir appliquer, donc c’est vraiment pertinent de prendre la peine de lui expliquer cela.

En bref, si une colonne contient des données en texte dont les valeurs doivent être considérées comme une échelle hiérarchisée, ça vaut vraiment la peine de le lui dire. Et ça se fait de manière très simple : “Considère les valeurs de la colonne “Réaction” comme hiérarchisées dans l’ordre suivant : “ignore” < “observe calmement” < “tendu mais parvient à gérer” < “pète un cable”.”, en lui indiquant bien toutes les valeurs possibles de notre questionnaire d’origine.

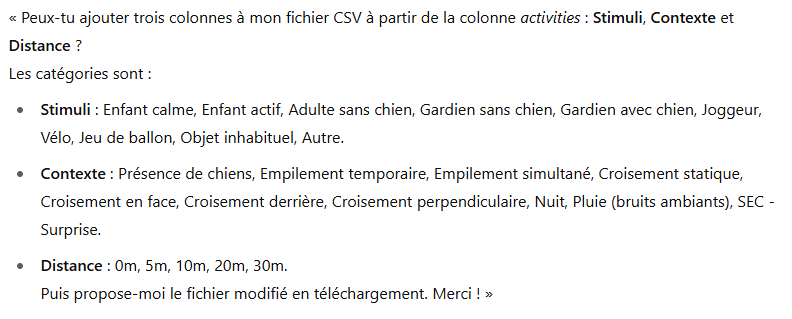

De même, si vous utilisez Daylio, il est probable que vous ayez regroupé vos paramètres (les “activités”) en sections (par exemple, un bloc avec les stimuli, un bloc avec les éléments de contexte, et un bloc avec les distances). Dans le fichier csv, tout ça est rassemblé dans une seule colonne. Or, pour l’analyse, vous avez probablement envie de considérer ces blocs séparément. Il est possible de demander à ChatGPT de créer de nouvelles colonnes pour splitter ces informations. Bien sûr, il ne peut pas deviner, dans cette colonne où tout est mélangée, ce qui appartient à quelle section : il faudra donc le lui indiquer, par exemple :

Il faut savoir que si vous travaillez avec un compte gratuit, ChatGPT n’a pas de mémoire d’une session à l’autre. Par contre, après une conversation où vous avez affiné toute une analyse, vous pouvez lui demander quelque chose du genre : “Si je voulais te redemander de faire la même chose lors d’une prochaine session, comment est-ce que je pourrais te le demander, pour être sûr que tu comprennes tout de suite ?”. Si vous lui demandez cela, il vous rédigera la requête (le « prompt« ) que vous pourrez copier quelque part pour la réutiliser la prochaine fois. Ca vous évitera par exemple de devoir retaper toutes ces étapes où vous lui décrivez vos données, alors que vous allez lui fournir le même fichier, formaté de la même manière, avec juste des lignes en plus qui se seront ajoutées. C’est d’ailleurs ce que j’ai fait pour obtenir le prompt ci-dessus : je lui ai demandé de le rédiger lui-même, pour l’utiliser uen prochaine fois.

Bien sûr, ici je présente cela de manière simple, mais au fur et à mesure vous allez aussi vous-même apprendre à être plus précis dans la façon dont vous interagissez avec ChatGPT… mais pour le moment, c’est déjà largement suffisant pour commencer.

‣ L’analyse proprement dite

Maintenant que notre dataset est nettoyé, nous allons pouvoir poser plein de questions à ChatGPT pour lui demander de repérer les corrélations. Cette partie est vraiment très modulable : on peut commencer par lui demander simplement quelque chose comme “J’essaie d’identifier les facteurs qui influencent la réaction de mon chien quand il est exposé à certains stimuli particuliers (déclencheurs). Peux-tu analyser les éventuelles corrélations entre certains facteurs (contexte, distance) et l’intensité de la réaction ?”. Il va alors analyser cela, et proposer de lui-même des analyses approfondies. Il dira par exemple “Il semble que les réactions sont plus intenses lorsqu’il fait nuit, mais il est possible que ce soit différent pour chaque déclencheur. Veux-tu que je fasse la même analyse séparément pour chaque déclencheur, pour voir s’il y a des différences ?”. On peut alors continuer la discussion, et affiner l’analyse.

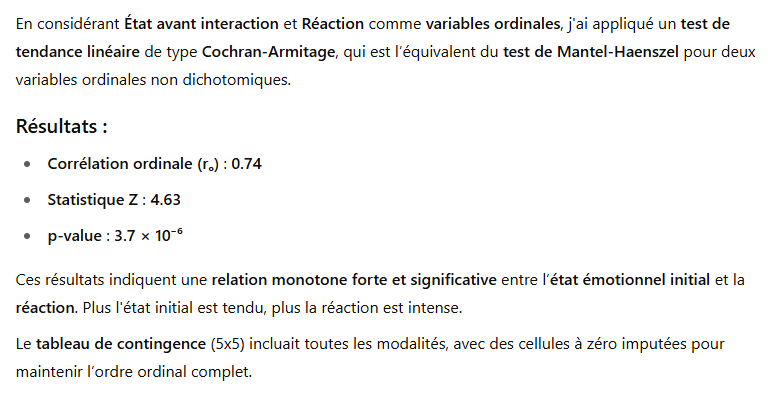

Il faut savoir qu’il s’adapte assez précisément à la demande, aux mots utilisés et au ton : il ne me répondra pas de la même façon si je lui demande : “Indique moi s’il y a une influence l’état avant interaction sur la réaction”, ou si je lui dis : “Applique un test Mantel-Haenszel à ces deux variables catégorielles ordinales”.

Dans le premier cas il me répond :

Dans le second cas il me répond :

Evidemment, je ne vais pas rentrer dans tous les détails ici, mais comme on le voit, il s’agit d’un outil très puissant, qui applique les mêmes méthodes d’analyse statistiques que ce qu’on ferait dans un logiciel comme SPSS ou en programmant nos analyse en R, mais avec une approche plus intuitive, qui nous évite de devoir transformer nous-mêmes nos données, sélectionner les bonnes méthodes, etc. On pourrait lui demander des analyses complexes : parfois, un facteur seul n’a pas d’influence, mais c’est la combinaison qui est problématique (par exemple, imaginons que mon chien ne réagit pas sur les enfants de jour, ni sur les autres stimuli la nuit, mais uniquement lorsqu’il voit un enfant la nuit). C’est un type d’analyse qu’il est capable de faire.

Bref, il y a vraiment moyen d’aller très loin sans pour autant avoir de compétences en analyse statistique, et de lui demander comment il a procédé pour bien comprendre… Et de nouveau, si une analyse nous parle, et qu’on voudrait pouvoir la réutiliser par la suite, on peut lui demander de générer le prompt à lui donner pour obtenir directement ce résultat à partir du fichier initial.

La visualisation

‣ ChatGPT

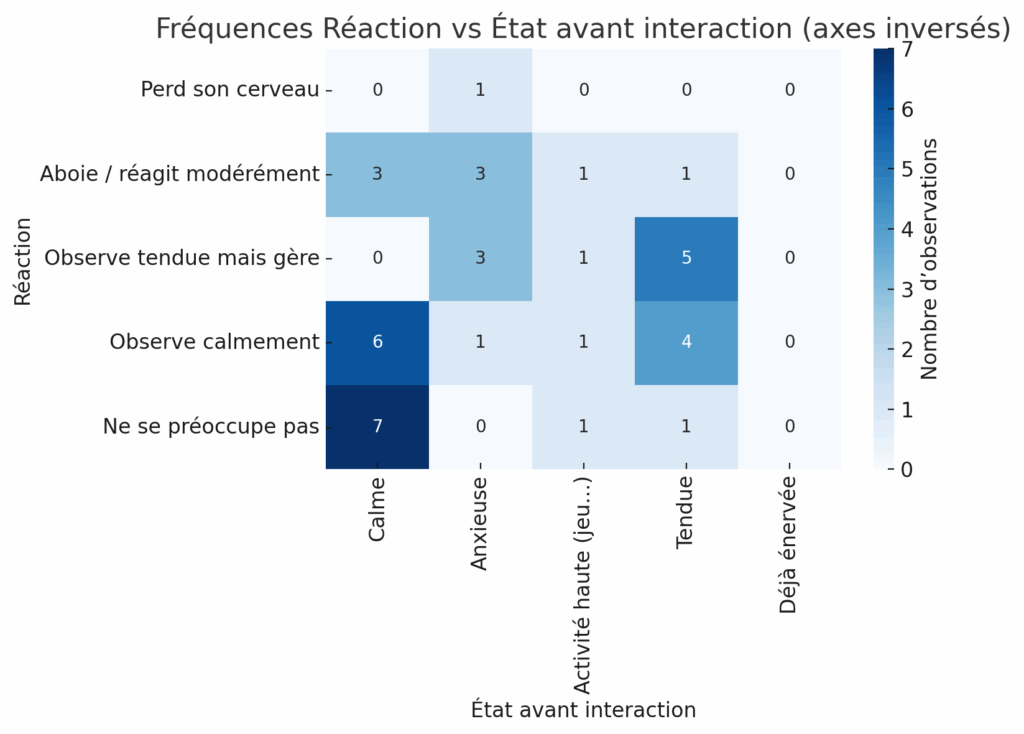

Souvent, il est plus pratique de pouvoir obtenir ces résultats d’analyse de manière visuelle, et ChatGPT le propose souvent de lui-même. Ca peut être une très bonne manière d’explorer les données. Voici un exemple de visualisation qu’il m’a faite (je lui ai demandé une heatmap de l’état avant interaction vs la réaction) :

C’est déjà très très chouette, mais on a parfois envie d’avoir une visualisation plus sympa, surtout si c’est pour la partager. Pour ça, il y a un chouette outil qu’on peut utiliser : Flourish.

‣ Flourish

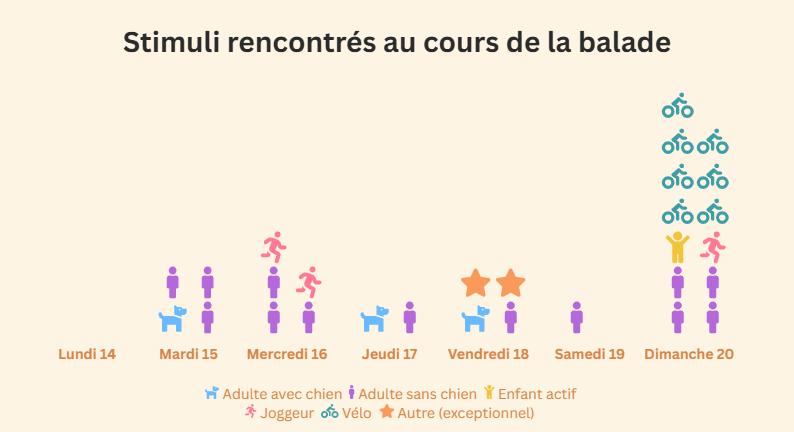

Flourish est une plateforme avec un accès gratuit très complet qui permet de sortir de belles visualisations de données. On peut importer notre fichier de données et le laisser nous proposer des visualisations, ce qui donne déjà une idée des possibilités…

Mais pour aller plus loin, on peut de nouveau faire appel à ChatGPT. Une fois qu’on sait ce qu’on veut obtenir dans Flourish, on peut lui demander de nous préparer le fichier, en lui disant par exemple “Je voudrais faire une visualisation dans Flourish de type barres empilées, avec une barre par jour et le total de réactions par type par jour, peux tu me préparer le fichier pour Flourish ?”. Evidemment, là c’est une visualisation simple, mais on peut faire des choses plus complexes, qui permettent de présenter les données de manière visuelle et interactive, par exemple pour réfléchir ensemble avec les gardien·ne·s. Voici un exemple de ce qu’on peut faire :

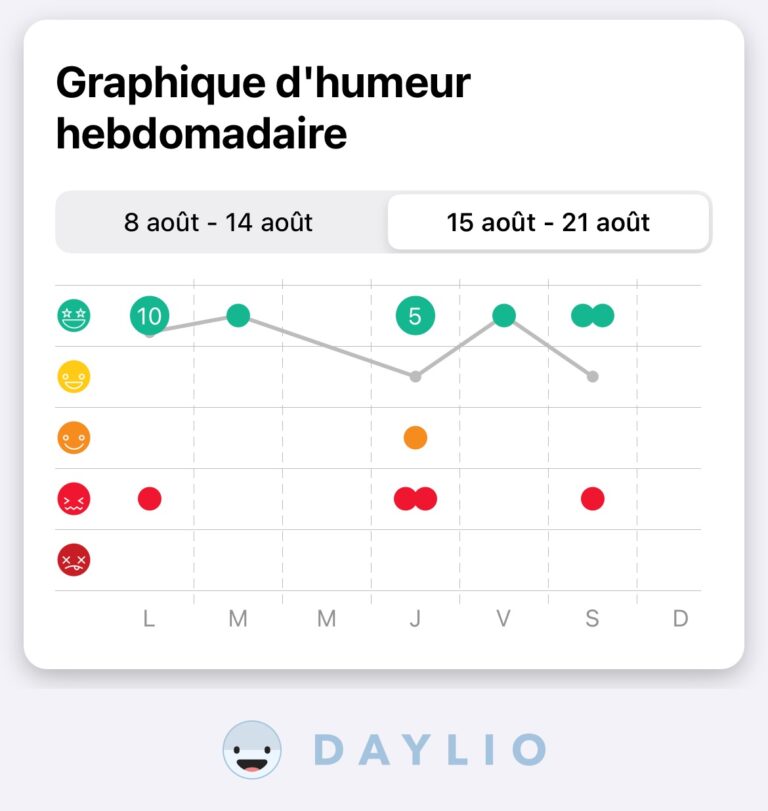

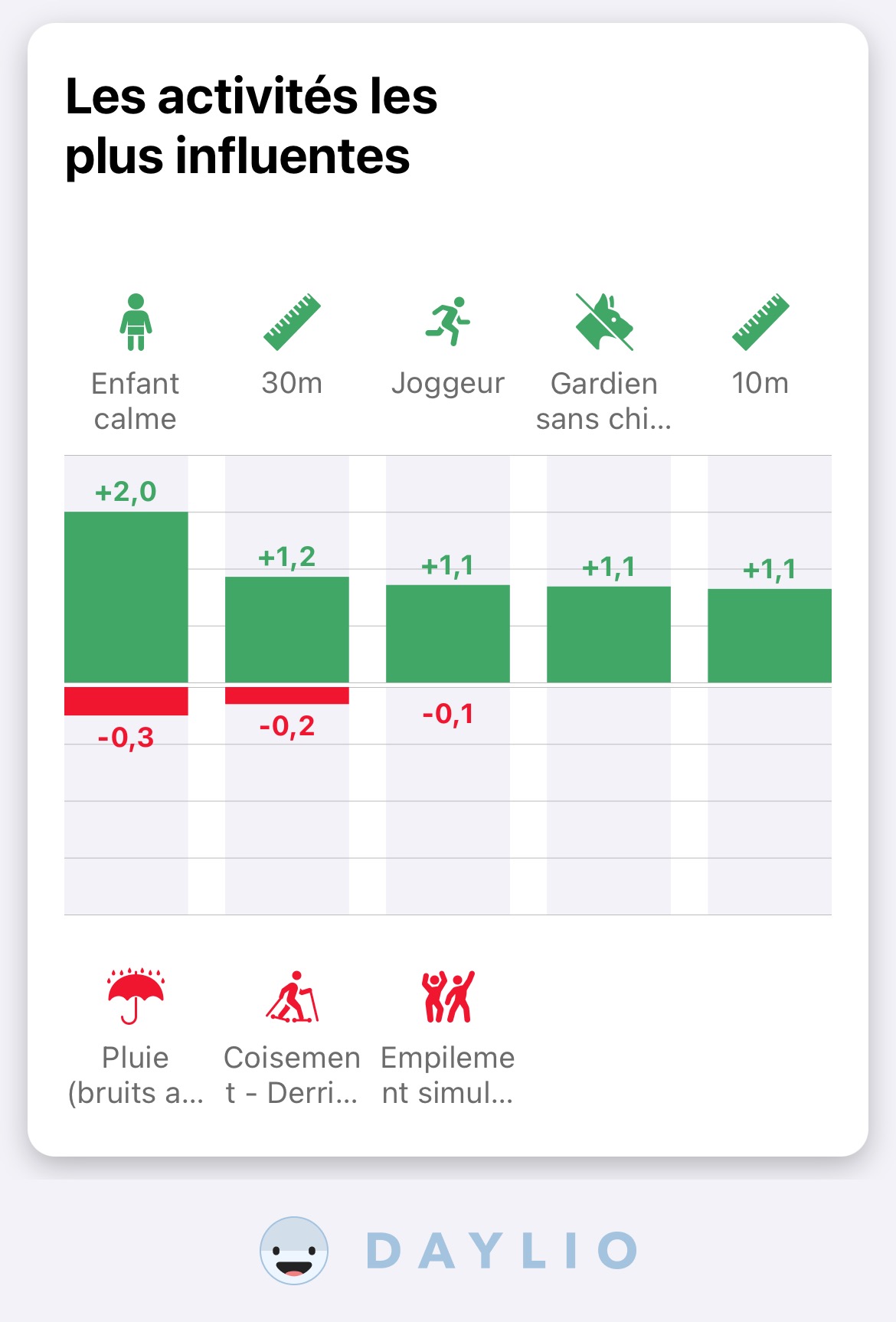

‣ Daylio

Si vous utilisez Daylio, vous savez déjà qu’il vous propose des analyses et des visualisations de lui-même, je ne vais donc pas revenir là-dessus… Si vous ne connaissez pas encore, je vous invite à aller voir l’article que je lui ai dédié. Voici un petit aperçu du type de visualisations qu’il propose :

Conclusion

Evidemment, la collecte et l’analyse des données ne sont que la première étape du travail d’analyse que vous ferez avec votre comportementaliste ou votre vétérinaire. Cela ne sert en aucun cas à remplacer ce travail, au contraire, cela sert à nourrir ce travail, à permettre à ce « village » autour de votre chien d’identifier précisément ce qui se passe, et ensuite, grâce à l’expérience, les connaissances, et la coopération de tout le monde, de pouvoir déterminer ou affiner les mesures à mettre en place tou·te·s ensemble, pour améliorer le bien-être physique et émotionnel de nos chiens…

J’espère que cet article vous aura été utile !